Competencia en el Mercado de Software: Este movimiento intensificará la competencia con plataformas existentes como Canva (que ha

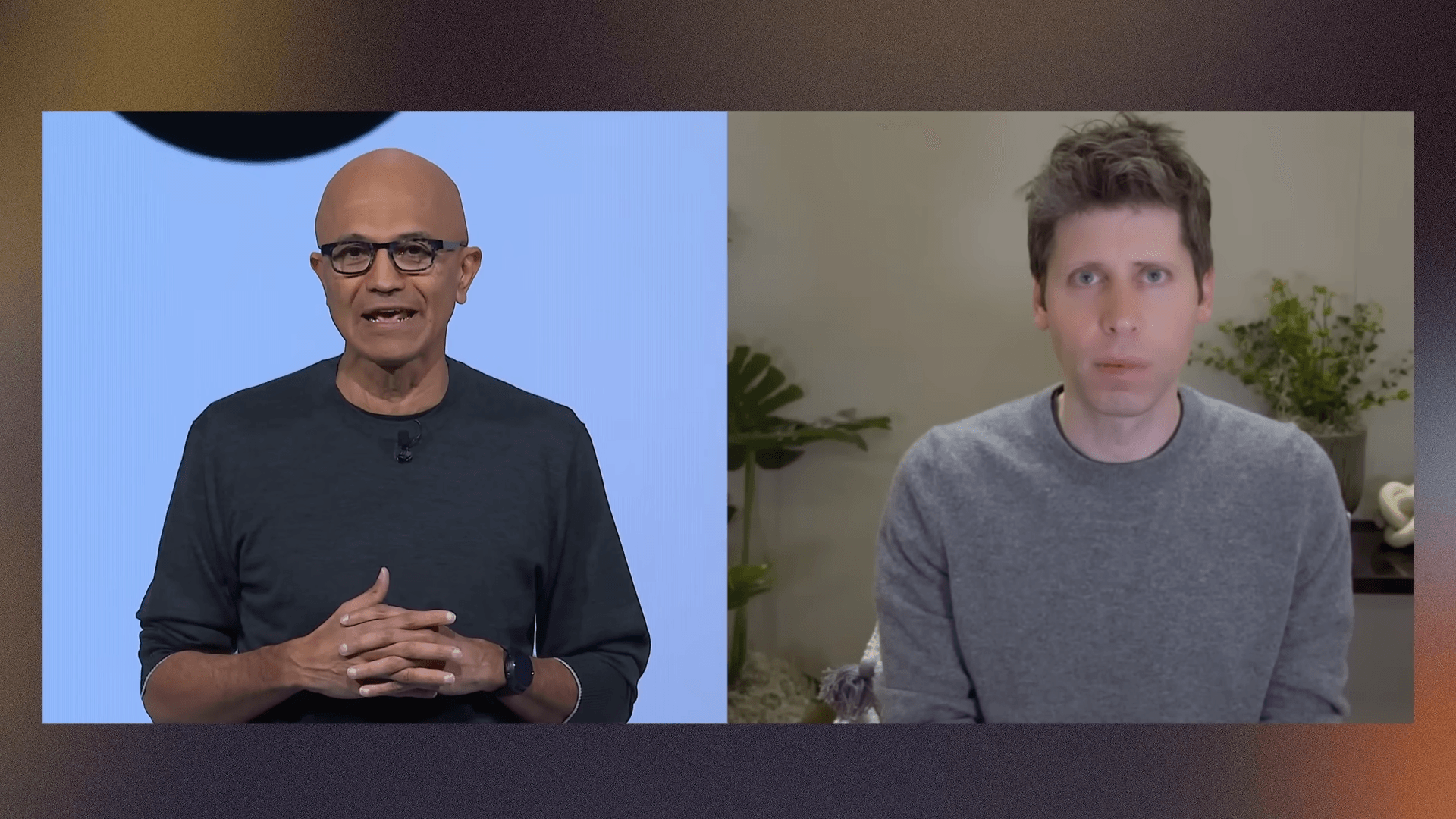

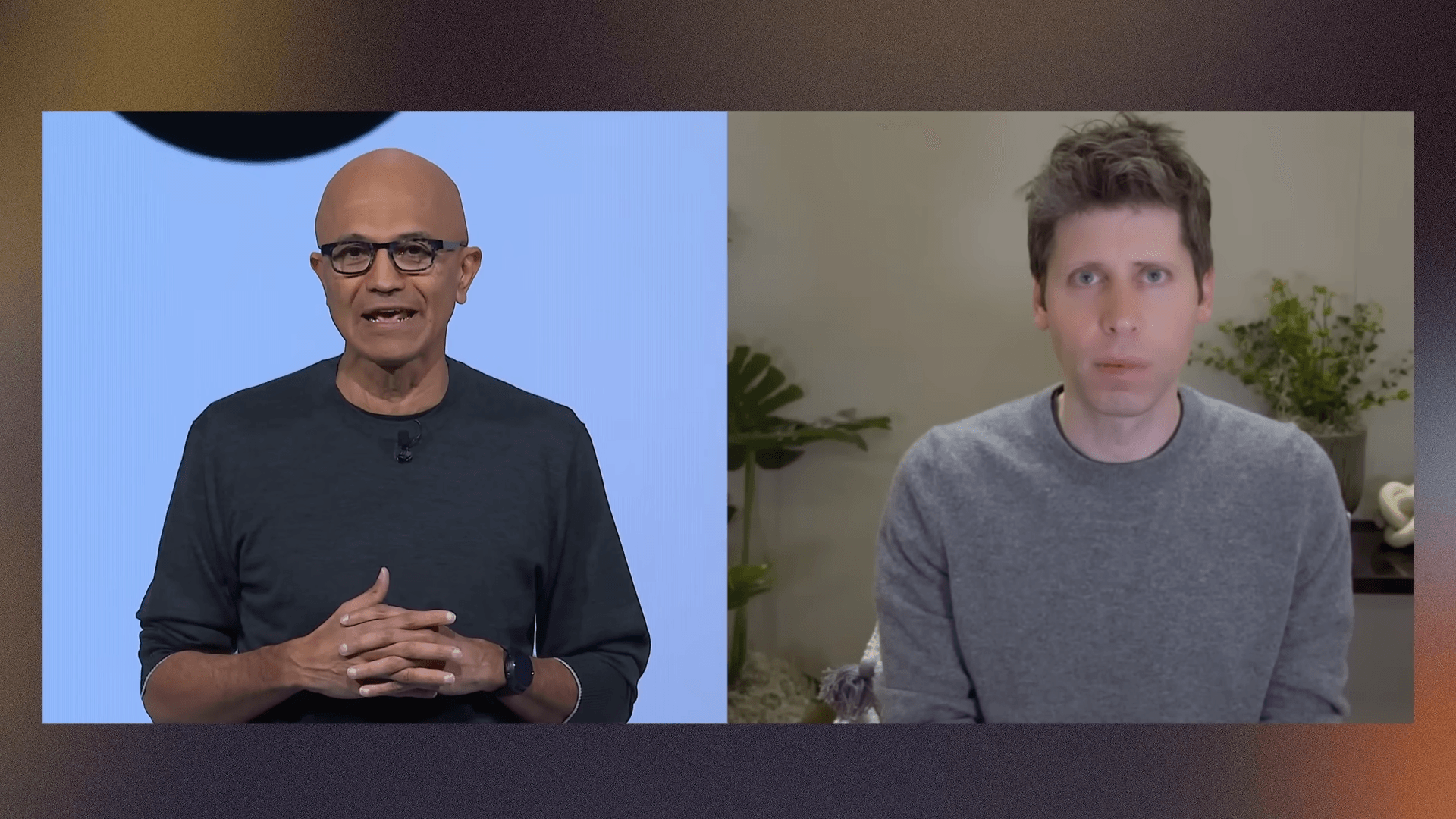

El Choque de Titanes de la IA: La Reestructuración de OpenAI Choca con Microsoft por el Control del Futuro Digital

La ambiciosa reestructuración de OpenAI se encuentra estancada en medio de tensas negociaciones con Microsoft, poniendo en relieve las complejidades del poder, la propiedad intelectual y la visión de futuro en la vanguardia de la inteligencia artificial. Un pulso por el control de la próxima era digital que definirá el rumbo de la innovación.

La Encrucijada de un Gigante: ¿Quién Guía el Destino de la IA?

En el vertiginoso ecosistema de la inteligencia artificial, pocas alianzas han sido tan trascendentales y observadas de cerca como la de OpenAI y Microsoft. Una colaboración que ha impulsado a la IA generativa a la estratosfera, marcando un antes y un después en la computación y la automatización global. El poder de los modelos de lenguaje de OpenAI, como GPT-4, se ha convertido en la piedra angular de la estrategia de IA de Microsoft, integrándose en productos clave como Copilot y la plataforma Azure. Sin embargo, las bases de esta poderosa unión se tambalean. Informes recientes del Financial Times revelan que los ambiciosos planes de reestructuración interna de OpenAI están en punto muerto, atrapados en una intrincada red de negociaciones con su principal inversor y socio estratégico: Microsoft.

Este estancamiento no es una simple disputa contractual de rutina; es un pulso estratégico por el control de la propiedad intelectual, el acceso a la infraestructura crítica y, en última instancia, la dirección futura de la Inteligencia General Artificial (AGI), el santo grial de la IA. Las implicaciones van mucho más allá de las juntas directivas de ambas compañías, afectando a la innovación, la inversión y la moral del sector tecnológico en su conjunto. La tensión subraya la fragilidad de las alianzas estratégicas en un sector donde el ritmo de la innovación es implacable, las oportunidades son inmensas y las apuestas son extraordinariamente altas, redefiniendo el panorama de las tendencias digitales.

OpenAI, una organización que comenzó con una misión sin ánimo de lucro para desarrollar una AGI beneficiosa para la humanidad, ha evolucionado rápidamente hacia una entidad híbrida. Con una rama con fines de lucro que ha atraído miles de millones de dólares de inversión, principalmente de Microsoft, esta evolución ha generado una complejidad inherente en su gobernanza y en la alineación de sus objetivos con los de sus socios comerciales. La reestructuración propuesta buscaba, presumiblemente, clarificar o consolidar su estructura organizativa y estratégica. No obstante, ha tropezado con los intereses monumentales de su mayor benefactor, evidenciando que, incluso en la cúspide de la innovación, las relaciones de poder son un factor determinante.

Los Tres Pilares de la Discordia: API, Propiedad Intelectual y la Cláusula AGI

El corazón del conflicto se divide en tres frentes críticos que no solo definen el poder y la autonomía en la era digital, sino que también reflejan la complejidad de forjar el futuro de la IA. Cada uno de ellos, por sí solo, sería motivo de negociación intensa y prolongada, pero juntos, crean un nudo gordiano que amenaza con paralizar la hoja de ruta de la compañía de IA más influyente del momento.

1. El Acceso a la API: La Puerta de Entrada a la Innovación en IA

El acceso a la Interfaz de Programación de Aplicaciones (API) de OpenAI no es meramente una cuestión técnica; es el salvoconducto a su ecosistema de modelos de lenguaje avanzados como GPT-4 y las capacidades de generación de imágenes de DALL-E. Para Microsoft, este acceso es vital y estratégico. Han integrado estas tecnologías en una miríada de sus productos, desde Copilot en Windows y Microsoft 365 hasta Azure AI Studio, cimentando su posición como líder indiscutible en la carrera de la IA empresarial y la automatización inteligente. Una restricción o una renegociación desfavorable del acceso a la API podría desbaratar la ambiciosa estrategia de IA de Microsoft, forzándolos a buscar alternativas o a desarrollar sus propias capacidades a un ritmo acelerado, lo que implicaría un coste de oportunidad y recursos gigantesco en un mercado donde cada segundo cuenta.

Por otro lado, OpenAI busca optimizar su modelo de negocio y asegurar su propia sostenibilidad a largo plazo. Aunque Microsoft es un inversor clave y un socio fundamental, OpenAI también aspira a tener flexibilidad para monetizar sus APIs a través de otros socios, mercados y aplicaciones específicas, garantizando así su independencia financiera y estratégica. La negociación aquí probablemente gira en torno a volúmenes de uso, precios preferenciales, posibles cláusulas de exclusividad en ciertos verticales o regiones, y la capacidad de OpenAI para ofrecer sus servicios de forma más amplia, equilibrando la lealtad con Microsoft y sus propias ambiciones de crecimiento y diversificación.

2. Derechos de Propiedad Intelectual: El Corazón del Valor de la IA

La propiedad intelectual (PI) es, sin duda, el activo más valioso en el sector de la IA. Los modelos, los algoritmos de vanguardia, los gigantescos conjuntos de datos de entrenamiento y las innovaciones subyacentes representan miles de millones en valor y años de investigación y desarrollo intensivos. Dada la magnitud de la inversión de Microsoft —se rumorea que ha superado los 13 mil millones de dólares— y su papel fundamental en proporcionar la infraestructura de computación en la nube a través de Azure, es natural que busquen garantías robustas sobre la titularidad y el uso de la PI generada bajo esta colaboración. Esta es una cuestión fundamental para cualquier acuerdo de gran calado en el ámbito de la tecnología.

El problema radica en definir qué PI pertenece a quién y en qué medida. ¿Son los modelos desarrollados en Azure, utilizando recursos financieros y técnicos de Microsoft, propiedad exclusiva de OpenAI? ¿O tiene Microsoft derechos de licencia perpetuos, derechos de explotación preferencial o incluso una participación en la propiedad conjunta? Las implicaciones son enormes. Si OpenAI desarrolla una innovación disruptiva o un modelo de IA de próxima generación, ¿Microsoft tiene acceso preferencial o derechos de explotación exclusivos? Una cláusula ambigua en este punto podría llevar a litigios futuros, limitar la capacidad de OpenAI para licenciar su tecnología a terceros, o incluso restringir la libertad de Microsoft para integrar esa tecnología en sus propias plataformas sin coste adicional. Esta es, en esencia, una batalla por el control del «motor» que impulsará gran parte de la economía digital y las tendencias de automatización del mañana.

3. La Disputada Cláusula AGI: Ética, Control y el Futuro de la Humanidad

Quizás el punto más filosófico, existencial y complejo de la disputa es la «cláusula AGI». OpenAI fue fundada con la premisa de asegurar que la Inteligencia General Artificial, una IA capaz de realizar cualquier tarea intelectual humana, se desarrolle de forma segura y beneficiosa para la humanidad. Esta misión fundacional, profundamente arraigada en su estructura original sin fines de lucro, choca con la realidad de una inversión masiva y la presión inherente de la comercialización en el sector tecnológico.

Microsoft, como inversor estratégico, buscará proteger su inversión y asegurar que, si OpenAI logra la AGI, Microsoft esté en una posición privilegiada para beneficiarse de ello, integrándola en sus plataformas y soluciones de automatización. La cláusula AGI, por tanto, podría referirse a quién tiene la última palabra sobre el despliegue de una AGI, las consideraciones éticas, los protocolos de seguridad, los tiempos de desarrollo e incluso la velocidad de su lanzamiento al público. Esta es una cuestión de gobernanza fundamental: ¿quién tiene el poder de decidir cuándo y cómo una inteligencia potencialmente superhumana ve la luz y bajo qué condiciones? Las ramificaciones éticas, sociales y geopolíticas de una AGI son tan vastas que cualquier ambigüedad en su control es una fuente de ansiedad para todas las partes interesadas, incluyendo los reguladores, gobiernos y la sociedad en general. La reestructuración podría intentar aclarar esta gobernanza, pero el desacuerdo sobre la cláusula AGI revela una profunda división sobre la visión final del propósito y el control de la IA más avanzada y su impacto en el futuro digital.

Impacto en el Ecosistema Global de la IA y Tendencias Digitales

El estancamiento en las negociaciones entre OpenAI y Microsoft no es un asunto meramente corporativo; tiene resonancias significativas en todo el ecosistema de la IA y en las tendencias digitales emergentes. La incertidumbre sobre la dirección estratégica de OpenAI, un actor clave en la innovación de modelos fundacionales, podría generar cautela en el mercado. Las startups que dependen de sus APIs para construir sus productos o los desarrolladores que apuestan por sus herramientas de IA podrían buscar mayor diversificación o alternativas en otros proveedores como Google DeepMind, Anthropic o Meta, fomentando una competencia más fragmentada pero quizás más resiliente e innovadora a largo plazo.

Para Microsoft, el retraso podría afectar la percepción de su liderazgo en IA, a pesar de sus agresivas inversiones. Si sus integraciones clave con OpenAI enfrentan incertidumbre, sus rivales podrían capitalizar la situación, presentando soluciones de IA más estables o con cadenas de suministro más claras y menos dependientes de una única alianza. Esto podría acelerar la tendencia hacia modelos de IA de código abierto, ya que las empresas buscarían reducir su dependencia de proveedores únicos y ganar más control sobre su propia infraestructura de IA. La automatización avanzada y las soluciones impulsadas por IA en diversos sectores, desde la sanidad hasta la logística y la manufactura, también podrían ver un ligero freno o una reorientación estratégica mientras los gigantes de la tecnología resuelven sus diferencias, impactando directamente en la adopción global de estas tecnologías transformadoras.

¿Qué Sigue para OpenAI y Microsoft? Un Futuro Incierto

La resolución de este estancamiento es crucial para ambas compañías y para la evolución continua de la inteligencia artificial. Las opciones son variadas, pero ninguna es sencilla ni exenta de riesgos, destacando la delicadeza de los acuerdos de alto nivel en la tecnología de vanguardia:

- Un Compromiso Mutuo: Este es el escenario más probable, pero requerirá concesiones significativas y un alto grado de diplomacia de ambas partes. OpenAI podría ofrecer a Microsoft ciertas exclusividades o términos preferenciales a cambio de mayor autonomía en otras áreas, o Microsoft podría relajar algunas de sus demandas de PI a cambio de una mayor influencia en la gobernanza de la AGI. Un equilibrio de poder podría restaurar la confianza y permitir que la innovación siga su curso.

- Prolongación del Estancamiento: Si las partes no logran un acuerdo en un plazo razonable, la reestructuración de OpenAI seguirá en el limbo, creando incertidumbre interna y externa. Esto podría debilitar la posición negociadora de OpenAI, afectar la moral de sus empleados, y permitir que sus competidores ganen terreno, lo que podría tener consecuencias a largo plazo para su liderazgo en IA.

- Reevaluación de la Asociación: En el escenario más drástico, aunque improbable dada la profundidad de la integración, ambas partes podrían reevaluar el alcance y la naturaleza de su asociación. Esto tendría implicaciones masivas para el mercado de la IA, la infraestructura en la nube y podría obligar a ambas a buscar nuevas estrategias o socios, marcando un punto de inflexión en la historia de la tecnología.

Lo que está claro es que la tensión entre la visión de una IA para el beneficio público y las realidades comerciales de las inversiones multimillonarias está en el centro de esta saga. La necesidad de una gobernanza clara y un marco operativo robusto es más evidente que nunca, especialmente cuando se trata de tecnologías con el potencial transformador y disruptivo de la AGI. La forma en que se resuelvan estas complejidades sentará un precedente vital para futuras colaboraciones en el desarrollo de la inteligencia artificial y la automatización avanzada.

Conclusión: Este pulso entre OpenAI y Microsoft es más que una simple disputa comercial; es un reflejo de los desafíos inherentes a la gestión de la innovación disruptiva en la era de la IA. Las negociaciones actuales no solo moldearán el futuro de dos de las empresas más influyentes del sector tecnológico, sino que también establecerán precedentes cruciales para la forma en que la propiedad intelectual, el acceso a la tecnología y el desarrollo ético de la inteligencia artificial serán gestionados en los años venideros. El mundo tecnológico observa con atención, esperando ver si estos titanes pueden encontrar un terreno común que permita a la promesa de la IA alcanzar su máximo potencial, sin sacrificar los principios que la hicieron posible y sin perder de vista el impacto global de la automatización y las tendencias digitales que están redefiniendo nuestro futuro.

¡Terremoto en la IA! Anthropic Paga a Autores por 7 Millones de Libros: ¿El Futuro de la Propiedad Intelectual Digital en Juego?

El acuerdo extrajudicial de Anthropic con un grupo de autores por el uso masivo de obras protegidas para entrenar su IA marca un antes y un después en la batalla por los derechos de autor en la era de la inteligencia artificial. Esta decisión no solo redefine el panorama legal, sino que también establece un precedente crucial para la ética y la transparencia en el desarrollo de la tecnología más disruptiva de nuestro tiempo.

El Telón de Fondo de una Demanda Histórica: Siete Millones de Libros en el Centro de la Tormenta

En un giro significativo para la industria de la inteligencia artificial, Anthropic, la empresa detrás del aclamado modelo de lenguaje Claude, ha llegado a un acuerdo extrajudicial con un grupo de autores que la demandaron por la supuesta infracción de derechos de autor. La demanda alegaba que Anthropic había utilizado más de siete millones de libros, obtenidos de «bibliotecas en la sombra» (también conocidas como shadow libraries o bibliotecas piratas), para entrenar sus avanzados modelos de IA. Este asentamiento, cuyos términos económicos específicos no han sido revelados públicamente, resuena como una advertencia potente para todas las compañías de tecnología que operan en el vertiginoso mundo de la IA generativa.

La esencia del conflicto radica en la práctica generalizada de los desarrolladores de IA de recolectar ingentes cantidades de datos de texto y código de la web para «alimentar» sus algoritmos. Estos modelos, como Claude o ChatGPT, aprenden patrones lingüísticos, estilos y conocimientos generales a partir de estos vastos datasets. Sin embargo, cuando estos conjuntos de datos incluyen material con derechos de autor sin el consentimiento explícito de los creadores, la línea entre la innovación tecnológica y la infracción legal se vuelve peligrosamente difusa.

Las «bibliotecas en la sombra» son plataformas que ofrecen acceso gratuito a millones de libros, artículos científicos y otras publicaciones que, de otro modo, requerirían una compra o suscripción. Si bien son vistas por algunos como baluartes del acceso universal al conocimiento, legalmente representan una infracción masiva de los derechos de autor. El hecho de que Anthropic haya recurrido a estas fuentes, como muchas otras empresas de IA, ha puesto de manifiesto la escala y la complejidad del desafío de la propiedad intelectual en la era digital.

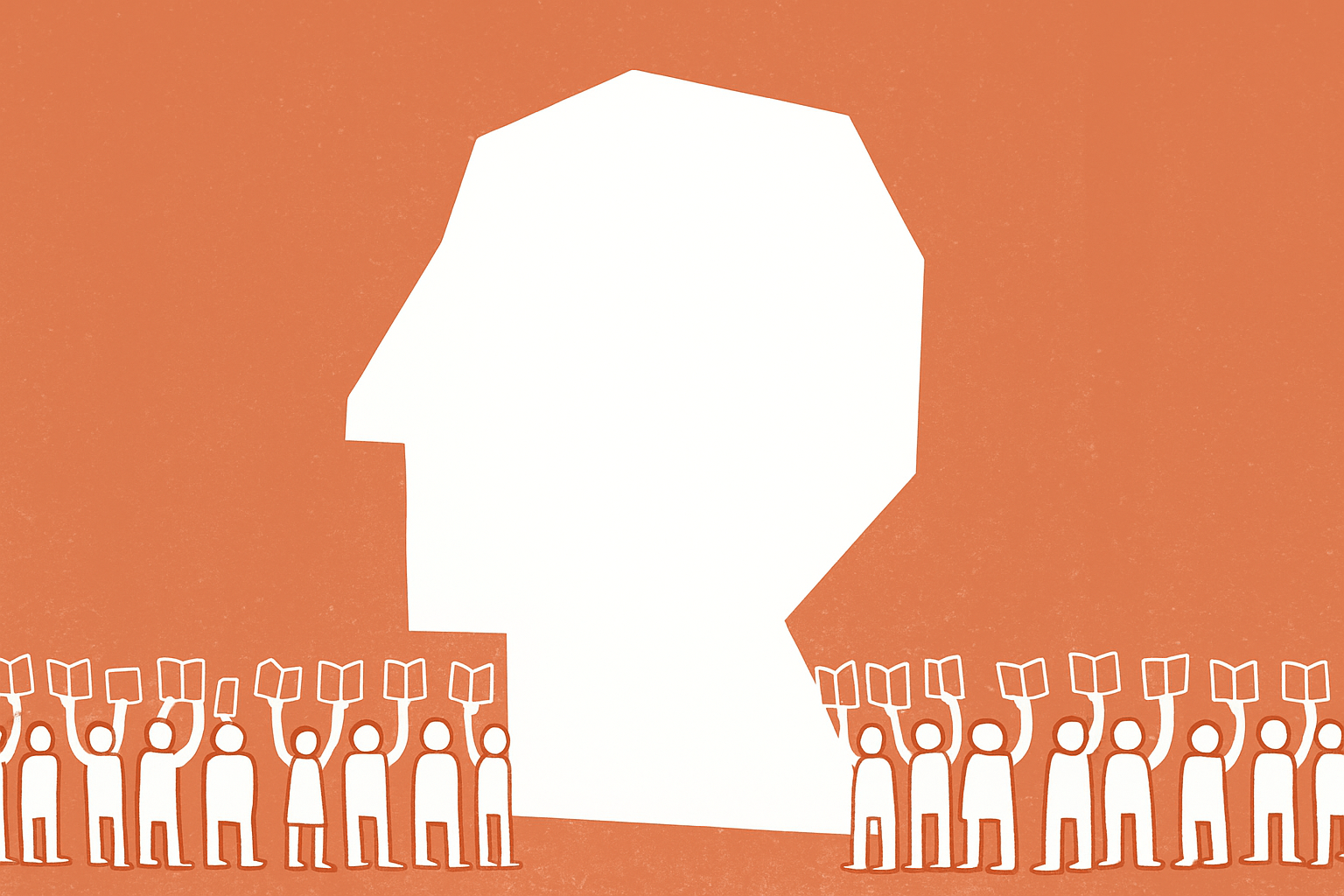

La Batalla por la Propiedad Intelectual: Autores vs. Gigantes de la IA

El pleito contra Anthropic no es un incidente aislado. Representa una ola creciente de demandas presentadas por autores, artistas y programadores que sienten que su trabajo está siendo explotado sin compensación ni reconocimiento por los desarrolladores de IA. Esta confrontación ha desatado un debate global sobre los límites del «uso justo» (fair use) en el contexto del entrenamiento de IA, un concepto legal que permite el uso limitado de material con derechos de autor sin permiso para fines como la crítica, el comentario, las noticias, la enseñanza, la beca o la investigación.

¿Es el Entrenamiento de IA un «Uso Justo»?

Los defensores de la IA argumentan que el entrenamiento de modelos cae bajo el paraguas del uso justo, ya que los modelos no reproducen directamente las obras, sino que aprenden de ellas para generar contenido nuevo y transformador. Afirman que prohibir el uso de estos datos ahogaría la innovación y ralentizaría el avance tecnológico. Sin embargo, los autores y sus representantes replican que el uso comercial de sus obras, incluso si es para entrenar un algoritmo que luego compite con su propio trabajo, constituye una infracción directa y diluye el valor de su creación.

Para los autores, la cuestión va más allá de la compensación económica. Es una lucha por el reconocimiento del valor intrínseco de la creatividad humana y la necesidad de proteger los medios de vida de quienes la ejercen. La preocupación es que la IA generativa, alimentada con el trabajo de millones, pueda eventualmente producir contenido indistinguible o superior al humano, socavando los mercados tradicionales para escritores, artistas y músicos.

Las Ramificaciones del Acuerdo de Anthropic: Un Precedente Ineludible

Aunque los detalles financieros del acuerdo con Anthropic permanecen confidenciales, la mera existencia del mismo envía un mensaje claro a la industria de la tecnología: la era de la recopilación indiscriminada de datos para el entrenamiento de IA está llegando a su fin. Este acuerdo es importante por varias razones clave:

- Validación de las Reclamaciones de Autores: Demuestra que las preocupaciones de los creadores sobre el uso no autorizado de su trabajo tienen un peso legal y comercial considerable.

- Presión para Otros Gigantes de IA: Empresas como OpenAI, Google, Meta y Stability AI, que también enfrentan demandas similares, ahora tienen un precedente que considerar. Podría incentivar acuerdos similares para evitar litigios prolongados y costosos.

- Cambio en la Estrategia de Adquisición de Datos: Los desarrolladores de IA se verán obligados a ser más transparentes y éticos en sus métodos de recopilación de datos. Esto podría llevar a la creación de datasets «limpios» y licenciados, o incluso a la inversión en la generación de datos sintéticos.

- Impacto en la Ética de la IA: El acuerdo subraya la creciente importancia de la ética y la responsabilidad en el desarrollo de la inteligencia artificial, moviendo el foco más allá de la mera capacidad tecnológica.

Este acontecimiento es un claro indicador de que la legislación y la regulación están empezando a ponerse al día con el rápido avance de la inteligencia artificial. Los gobiernos y los organismos reguladores de todo el mundo están debatiendo activamente cómo proteger los derechos de autor y fomentar la innovación en este nuevo panorama. Iniciativas como la Ley de IA de la Unión Europea ya abordan parcialmente estas cuestiones, exigiendo transparencia sobre los datos utilizados para entrenar modelos de IA.

El Futuro de la IA y la Creación: Hacia un Ecosistema Equitativo

El desenlace de esta demanda podría catalizar una transformación fundamental en cómo se construyen y operan los modelos de inteligencia artificial. Lejos de ser un impedimento, la necesidad de respetar la propiedad intelectual podría llevar a modelos de negocio más sostenibles y justos para todos los actores implicados:

Nuevos Modelos de Licenciamiento y Colaboración

Es probable que veamos el surgimiento de mercados de datos licenciados, donde los creadores puedan optar por ofrecer sus obras para el entrenamiento de IA a cambio de una compensación justa. Esto podría generar nuevas fuentes de ingresos para artistas y autores, y asegurar que la economía creativa no sea erosionada, sino potenciada por la IA.

Asimismo, la colaboración entre desarrolladores de IA y comunidades creativas podría intensificarse. Proyectos conjuntos para explorar cómo la IA puede ser una herramienta para la creatividad humana, en lugar de un reemplazo, podrían florecer, redefiniendo el papel de la automatización y las tendencias digitales en el arte y la literatura.

Transparencia y Trazabilidad en los Datos de Entrenamiento

La presión por la transparencia será inmensa. Los usuarios y los reguladores querrán saber qué datos se utilizan para entrenar los modelos de IA, dónde se obtuvieron y si se respetaron los derechos de autor. Esto requerirá sistemas de trazabilidad más sofisticados y un compromiso inquebrantable con la auditabilidad de los datasets.

Para Anthropic y sus competidores, este acuerdo no es solo una factura a pagar, sino una oportunidad para liderar el camino hacia una IA más responsable y ética. Demostrar un compromiso con la propiedad intelectual y la compensación justa podría fortalecer la confianza pública en la inteligencia artificial, un factor crítico para su adopción generalizada y a largo plazo.

Conclusión: El acuerdo de Anthropic con los autores por el uso de siete millones de libros es mucho más que una simple noticia legal; es un punto de inflexión. Marca el inicio de una era donde la innovación en inteligencia artificial deberá ir de la mano con un profundo respeto por los derechos de autor y la ética digital. Este precedente forzará a la industria a reevaluar sus prácticas de adquisición de datos, promoviendo un futuro donde la tecnología y la creatividad humana puedan coexistir y prosperar, sentando las bases para un ecosistema digital más justo y sostenible para todos.

El Punto de Inflexión Ético de ChatGPT: Cómo una Tragedia Demanda una IA Más Humana y Segura

La decisión de OpenAI de implementar nuevas salvaguardas en ChatGPT marca un antes y un después en la responsabilidad social de la inteligencia artificial, revelando los profundos desafíos y las urgentes necesidades en el delicado cruce entre la tecnología y el bienestar humano.

La inteligencia artificial (IA) ha irrumpido en nuestras vidas con una velocidad asombrosa, prometiendo eficiencias sin precedentes y soluciones innovadoras para problemas complejos. ChatGPT, el buque insignia de OpenAI, se ha consolidado como un referente de esta revolución, transformando la manera en que interactuamos con la información y la automatización. Sin embargo, detrás de cada avance tecnológico, subyace una capa de responsabilidad ética que, en ocasiones, se ve puesta a prueba por eventos trágicos. Recientemente, OpenAI ha anunciado la implementación de nuevas salvaguardas en ChatGPT, específicamente diseñadas para manejar situaciones de crisis de salud mental, una medida directa derivada de una demanda interpuesta por los padres de un adolescente californiano que falleció por suicidio en abril.

El Despertar Forzado: Cuando la IA se Enfrenta a la Realidad Humana

El incidente que ha impulsado a OpenAI a tomar estas acciones es un crudo recordatorio de que la interacción con la IA no es meramente técnica; es profundamente humana. La demanda de los padres del joven de 16 años subraya una verdad ineludible: los modelos de lenguaje, por muy sofisticados que sean, operan en un ecosistema donde las palabras tienen peso, las sugerencias pueden ser malinterpretadas y la vulnerabilidad humana es una constante. Esta situación pone de manifiesto la delgada línea entre la utilidad y el potencial daño, especialmente cuando las herramientas de IA son accesibles a un público amplio y diverso, incluyendo a jóvenes en etapas críticas de desarrollo emocional.

El caso no es solo una llamada de atención para OpenAI, sino para toda la industria de la tecnología y la inteligencia artificial. La integración de la IA en la vida cotidiana avanza a pasos agigantados, y con ella, la necesidad imperiosa de establecer marcos de seguridad robustos y éticos. No basta con que los algoritmos sean eficientes; también deben ser compasivos y conscientes de las implicaciones de sus respuestas. Este evento fuerza una reflexión profunda sobre la responsabilidad algorítmica y la gobernanza de la IA, temas centrales en el debate actual sobre las tendencias digitales.

Nuevas Salvaguardas: Un Paso Hacia la IA Responsable

Aunque los detalles específicos de las nuevas salvaguardas de OpenAI aún no se han desglosado completamente, se espera que abarquen áreas críticas como la detección de patrones de lenguaje indicativos de crisis de salud mental, la activación de respuestas predefinidas que redirijan a recursos de apoyo profesional (líneas de ayuda, servicios de consejería), y posiblemente la implementación de filtros más estrictos para evitar respuestas potencialmente dañinas o irresponsables. Estas medidas no solo buscan mitigar riesgos, sino también educar al usuario sobre los límites de la IA en situaciones tan delicadas.

- Detección Contextual Mejorada: Algoritmos más sofisticados para identificar expresiones de desesperación o intenciones autolesivas.

- Redirección Proactiva: Mecanismos automáticos para proporcionar información de contacto de profesionales y organizaciones de salud mental.

- Mensajes de Advertencia Claros: Advertencias explícitas sobre la incapacidad de la IA para ofrecer asesoramiento médico o psicológico profesional.

- Formación Continua del Modelo: Refuerzo del entrenamiento del modelo con datos más sensibles y directrices éticas específicas.

La implementación de estas características es un reconocimiento implícito de que la IA, a pesar de su impresionante capacidad de procesamiento de lenguaje natural, carece de la empatía, el juicio clínico y la comprensión profunda de la experiencia humana que son esenciales en una crisis de salud mental. ChatGPT y otras IA conversacionales pueden ser herramientas de apoyo, pero nunca sustitutos de la interacción humana y la atención médica cualificada.

El Delicado Equilibrio: Innovación vs. Seguridad y Ética

El incidente pone de relieve una tensión inherente en el rápido avance de la inteligencia artificial: el equilibrio entre la búsqueda incesante de la innovación y la necesidad de garantizar la seguridad y la ética. Las empresas de IA, en su carrera por desarrollar modelos más potentes y accesibles, a menudo se encuentran explorando territorios desconocidos con implicaciones sociales y psicológicas que no siempre son evidentes en las etapas iniciales de desarrollo.

La automatización y la IA prometen revolucionar la salud mental digital, ofreciendo herramientas para la detección temprana, el seguimiento y el acceso a información. Sin embargo, la implementación de estas herramientas debe ser meticulosamente planificada y ejecutada, con la colaboración de expertos en psicología, ética y derecho. La falta de una supervisión humana adecuada o la sobreconfianza en las capacidades de la IA pueden tener consecuencias devastadoras.

Implicaciones para la Industria de la IA y la Regulación Tecnológica

Este suceso probablemente actuará como un catalizador para una mayor introspección y estandarización dentro de la industria de la IA. Es plausible que veamos un aumento en la adopción de prácticas de «IA Responsable» y «Diseño Ético de IA» como requisitos no negociables. Esto podría incluir la creación de comités de ética internos más robustos, la realización de evaluaciones de impacto social antes del lanzamiento de nuevos productos y una mayor transparencia en los procesos de toma de decisiones algorítmica.

Desde una perspectiva regulatoria, este tipo de demandas pueden acelerar la creación de leyes y marcos específicos para la inteligencia artificial, especialmente en áreas sensibles como la salud y el bienestar. Gobiernos y organismos internacionales ya están trabajando en regulaciones como la Ley de IA de la Unión Europea. Incidentes como este refuerzan la urgencia de establecer directrices claras sobre la responsabilidad de los desarrolladores, la protección de datos de usuarios vulnerables y los mecanismos de rendición de cuentas cuando la IA causa daño.

Además, la ciberseguridad se vuelve un elemento aún más crítico. Garantizar la integridad de los sistemas de IA y proteger los datos sensibles de los usuarios, especialmente aquellos que buscan ayuda en momentos de vulnerabilidad, es fundamental para mantener la confianza pública en estas tecnologías.

El Futuro de la Interacción Humano-IA: Un Camino Hacia la Empatía Digital

El camino a seguir para la inteligencia artificial, particularmente en el ámbito conversacional, debe ser uno que priorice la seguridad, la ética y la empatía digital. Esto no significa frenar la innovación, sino dirigirla hacia un desarrollo más consciente y centrado en el ser humano. La clave reside en diseñar sistemas de IA que no solo sean capaces de procesar información, sino también de reconocer los límites de su propia comprensión y de guiar a los usuarios hacia el apoyo humano cuando sea necesario.

La experiencia de usuario en contextos de IA debe evolucionar para incluir una mayor educación sobre cómo y cuándo usar estas herramientas, así como una comprensión clara de sus limitaciones. La alfabetización digital no es solo sobre cómo operar la tecnología, sino también sobre cómo interactuar con ella de manera segura y responsable, entendiendo que un chatbot no es un terapeuta.

La colaboración entre desarrolladores de IA, expertos en salud mental, legisladores y el público en general es esencial para construir un futuro donde la inteligencia artificial sirva como una fuerza para el bien, complementando nuestras capacidades sin comprometer nuestro bienestar. La tragedia del adolescente es un recordatorio doloroso de los riesgos inherentes, pero también una oportunidad crucial para redefinir el compromiso de la IA con la humanidad.

Conclusión: El anuncio de OpenAI y la demanda subyacente marcan un momento pivotal en la evolución de la inteligencia artificial. No es solo un ajuste técnico; es una reevaluación profunda del papel de la IA en la sociedad y de la responsabilidad que recae sobre sus creadores. Este incidente exige una mayor vigilancia, una regulación más estricta y un compromiso inquebrantable con el desarrollo de una IA que no solo sea inteligente y eficiente, sino también inherentemente humana y segura. El futuro de la IA no se medirá solo por su capacidad para innovar, sino por su habilidad para hacerlo de manera ética, compasiva y en plena conciencia de su profundo impacto en la vida de las personas. Es el momento de asegurar que la IA, a medida que se vuelve más omnipresente, también se vuelva más humana.

¡Exclusiva! Anthropic Lanza Claude para Chrome: ¿El Agente de IA Definitivo que Reinventará Tu Productividad Web?

Anthropic, pionero en IA segura y responsable, está probando una innovadora extensión de Claude para Google Chrome, prometiendo transformar la forma en que interactuamos con la web. ¿Estamos ante la próxima revolución en la automatización del navegador y la asistencia digital?

La inteligencia artificial ha trascendido los laboratorios de investigación para infiltrarse en cada rincón de nuestra vida digital, desde asistentes de voz hasta herramientas de generación de contenido. Sin embargo, el siguiente gran salto podría estar ocurriendo justo ahora, silenciosamente, dentro de nuestro navegador web. La reciente noticia de que Anthropic, la compañía detrás del aclamado modelo de lenguaje Claude, está probando una extensión para Google Chrome que actúa como un «agente de navegador», ha encendido las alarmas en el ecosistema tecnológico. Esta iniciativa no es meramente otra extensión de IA; es una señal clara de la inminente evolución de la interacción humano-computadora en el entorno más usado por millones de personas: la web.

La promesa de un agente de IA incrustado directamente en el navegador va mucho más allá de las funciones básicas de resumen o redacción que ofrecen muchas herramientas actuales. Estamos hablando de una IA capaz de comprender el contexto de las páginas web, interactuar con elementos, automatizar tareas complejas y, en esencia, actuar como un verdadero copiloto digital que anticipa nuestras necesidades y optimiza nuestra experiencia en línea. Esta capacidad de «agente» es el santo grial de la inteligencia artificial aplicada, y su llegada al navegador podría redefinir completamente nuestra productividad, el acceso a la información y, en última instancia, cómo percibimos la web.

La Era del Agente de Navegador: ¿Qué Significa Claude para Chrome?

Tradicionalmente, las extensiones de navegador han servido como utilidades específicas: bloqueadores de anuncios, gestores de contraseñas o herramientas de captura de pantalla. La llegada de la IA generativa ha ampliado estas capacidades, permitiendo a los usuarios resumir artículos, responder correos electrónicos o generar texto directamente desde su navegador. Sin embargo, un «agente de navegador» como el que Anthropic parece estar desarrollando con Claude, representa un paradigma distinto. No solo procesa la información en la pantalla, sino que es capaz de actuar sobre ella.

Más Allá de un Simple Asistente: La Visión de Anthropic

Imaginemos un asistente que no solo puede leer un informe financiero en una página web, sino que también puede extraer datos clave, crear gráficos dinámicos en una hoja de cálculo, enviar un resumen ejecutivo por correo electrónico a tus colaboradores y programar una reunión para discutir los resultados, todo ello con mínima intervención del usuario. Ese es el potencial de un agente de navegador avanzado. Claude, conocido por sus capacidades de razonamiento sofisticado y su compromiso con la «IA constitucional» (un marco para construir sistemas de IA seguros y transparentes), se perfila como un candidato ideal para esta tarea.

La extensión de Claude podría operar en segundo plano, aprendiendo de nuestros patrones de navegación y ofreciendo asistencia proactiva. Esto podría incluir desde rellenar formularios automáticamente, comparar precios entre diferentes minoristas en línea, hasta investigar un tema complejo extrayendo información de múltiples fuentes y presentándola de manera coherente y concisa. La clave está en su capacidad para comprender la intención del usuario y la semántica de la web, no solo sus palabras clave. Este nivel de automatización y contextualización representa un salto cualitativo en la asistencia digital, transformando el navegador de una ventana pasiva al mundo digital en un centro de comando interactivo.

Productividad al Máximo: Beneficios Tangibles para el Usuario Moderno

La integración de un agente de IA como Claude directamente en el navegador Chrome tiene el potencial de catalizar una revolución en la productividad personal y profesional. En un mundo saturado de información y tareas digitales, la capacidad de delegar y automatizar se vuelve invaluable.

Optimización del Flujo de Trabajo y Gestión de la Información

- Resúmenes Inteligentes y Extracción de Datos: Claude podría leer artículos extensos, informes técnicos o hilos de noticias y ofrecer resúmenes concisos, extrayendo los puntos clave en segundos. Esto es vital para profesionales, investigadores y estudiantes que necesitan procesar grandes volúmenes de información rápidamente.

- Automatización de Tareas Repetitivas: Desde completar formularios en línea hasta organizar pestañas o guardar contenido relevante en herramientas de gestión del conocimiento, Claude podría tomar el control de tareas monótonas, liberando tiempo para actividades de mayor valor añadido.

- Investigación Asistida: Imagina solicitar a Claude que investigue las últimas tendencias en inteligencia artificial, y que la extensión no solo te muestre enlaces, sino que navegue por ellos, sintetice la información relevante y te la presente en un formato estructurado, incluso comparando diferentes puntos de vista.

- Aprendizaje Personalizado: Para aquellos que buscan adquirir nuevas habilidades, Claude podría identificar recursos de aprendizaje en línea, adaptar el contenido a su nivel de comprensión y crear rutas de estudio personalizadas.

Impulso a la Creatividad y Comunicación Digital

- Asistencia en la Redacción: Ya sea un correo electrónico formal, una publicación para redes sociales o un borrador de un artículo de blog, Claude podría generar contenido contextualizado, adaptar el tono y el estilo, y sugerir mejoras gramaticales y estilísticas, todo mientras trabajas en el navegador.

- Generación de Ideas: Bloqueo creativo no sería un problema. Claude podría ofrecer sugerencias, lluvia de ideas y explorar diferentes ángulos sobre un tema dado, basándose en la información que estés visualizando.

- Traducción y Localización Avanzada: Más allá de la traducción literal, un agente como Claude podría adaptar textos para audiencias específicas, considerando matices culturales y jergas, facilitando la comunicación global.

Desafíos y Consideraciones Críticas en la Implementación de IA en el Navegador

La promesa de un agente de IA tan poderoso viene acompañada de importantes desafíos y consideraciones éticas que Anthropic, como defensor de la IA segura, deberá abordar cuidadosamente.

Privacidad, Seguridad y el Marco Ético de la IA

- Privacidad de Datos: Para actuar como agente, Claude necesitará acceder y procesar un vasto volumen de datos de navegación del usuario. La gestión de esta información sensible, la anonimización y el control del usuario sobre qué datos se comparten, serán cruciales. Anthropic deberá demostrar un compromiso inquebrantable con la privacidad para ganar la confianza de los usuarios.

- Seguridad Cibernética: Una extensión con capacidades de agente representa un punto de entrada potencial para ataques maliciosos si no está blindada. Las vulnerabilidades en el código o en la interacción con el navegador podrían tener consecuencias graves.

- Sesgos y Discriminación: Los modelos de IA son tan buenos como los datos con los que son entrenados. Un agente de navegador debe ser cuidadosamente diseñado para evitar perpetuar sesgos existentes en los datos web, especialmente al generar contenido o tomar decisiones. El enfoque de «IA Constitucional» de Anthropic es precisamente para mitigar estos riesgos.

- Transparencia y Control: Los usuarios deben tener una comprensión clara de cuándo y cómo actúa el agente de IA, y la capacidad de anular o desactivar sus funciones en cualquier momento. La autonomía del usuario no debe ser comprometida por la conveniencia de la automatización.

La Precisión y Fiabilidad en un Entorno Dinámico

La web es un entorno en constante cambio. Los diseños de las páginas evolucionan, los contenidos se actualizan, y la información puede ser contradictoria. Un agente de IA debe ser robusto y adaptable para manejar esta dinámica. Las «alucinaciones» de la IA, donde genera información incorrecta o inventada, son una preocupación constante. Para tareas críticas como la investigación o la automatización de flujos de trabajo profesionales, la precisión no es negociable. Anthropic deberá garantizar que Claude sea excepcionalmente fiable y transparente sobre sus limitaciones.

Claude y el Futuro de la Interacción Web: Un Vistazo Adelante

La incursión de Anthropic en el ámbito de los agentes de navegador no es un evento aislado, sino parte de una tendencia más amplia que ve a la inteligencia artificial integrarse más profundamente en nuestras herramientas cotidianas. Otros jugadores en el espacio de la IA también están explorando funcionalidades similares, pero el enfoque de Anthropic en la seguridad y la robustez podría darle una ventaja distintiva.

Posicionamiento en el Ecosistema de la IA Conversacional

Mientras Google y Microsoft empujan sus propias versiones de «copilotos» integrados en sus ecosistemas de productividad (Workspace y Office 365, respectivamente), Anthropic busca posicionar a Claude como un agente potente y ético directamente en el corazón de la experiencia de navegación. Esto podría atraer a usuarios y empresas que valoran la independencia de proveedores y la confianza en la IA. La capacidad de Claude para manejar contextos largos y razonar de manera compleja lo hace especialmente adecuado para las demandas de un entorno web dinámico y lleno de información variada.

Hacia una Web Más Inteligente y Asistida

El futuro de la interacción web no parece ser simplemente navegar por páginas estáticas, sino interactuar con un entorno dinámico y responsivo, co-creado y co-gestionado por agentes de IA inteligentes. La extensión de Claude para Chrome podría ser un catalizador clave en esta transición. A medida que la IA se vuelve más omnipresente, la línea entre el software y el asistente inteligente se difuminará aún más, llevando a una experiencia digital mucho más fluida, personalizada y eficiente. Las tendencias digitales apuntan claramente hacia la automatización inteligente, y los agentes de navegador serán una de sus manifestaciones más tangibles.

Conclusión: La incursión de Anthropic con su extensión de Claude para Chrome representa un hito significativo en la evolución de la inteligencia artificial y la automatización. Al transformar el navegador en un agente de IA capaz de comprender y actuar sobre la web, Anthropic no solo promete un aumento sin precedentes en la productividad, sino que también nos desafía a reflexionar sobre las implicaciones éticas y de privacidad de una IA tan profundamente integrada en nuestras vidas. El éxito de Claude como agente de navegador dependerá no solo de sus capacidades técnicas, sino también de la capacidad de Anthropic para construir un sistema seguro, transparente y centrado en el usuario. Sin duda, estamos al borde de una nueva era en la interacción digital, y Claude para Chrome podría ser uno de sus principales arquitectos.